В мире AI-ассистентов для программирования сейча есть неоспоримый король — GitHub Copilot. Удобный, интегрированный, работающий «из коробки». Но у этой удобности всегда была обратная сторона: вы отдаете свой код и контекст на обработку в облако Microsoft, а о какой-либо серьезной кастомизации или self-hosted вариантах можно было только мечтать.

И вот Mistral AI выкатили анонс, в котором представили полноценный, интегрированный стек для AI-разработки, включающий обновленный Codestral 25.08, систему семантического поиска Codestral Embed и агентные воркфлоу Devstral.

Главный посыл — это решение создано для enterprise-сегмента, который задыхается от ограничений SaaS-инструментов. Но если копнуть глубже, окажется, что этот релиз важен для всех, кто ценит контроль над своими данными и инструментами. Давайте разберемся, что именно нам предлагают, как это работает и действительно ли у GitHub Copilot появился серьезный конкурент, которого можно развернуть у себя на сервере.

Почему корпорации до сих пор боятся AI-ассистентов?

Прежде чем нырять в сам стек, давайте на минуту зафиксируем, а в чем, собственно, проблема? Почему, несмотря на весь хайп, крупные компании, особенно из финансового сектора, здравоохранения или оборонки, не спешат внедрять Copilot и аналоги в свои процессы? Анонс Mistral четко бьет по этим болевым точкам.

- Жесткие ограничения по развертыванию. Большинство инструментов — это SaaS в чистом виде. Нет опций для развертывания в частном облаке (VPC), на собственных серверах (on-premise) или в полностью изолированных («air-gapped») средах. Для любой компании, работающей с чувствительными данными, это непреодолимый барьер.

- Невозможность кастомизации. У вас гигантская кодовая база со своими уникальными конвенциями, библиотеками и паттернами? Удачи в объяснении этого Copilot'у. Без доступа к весам модели и возможности ее дообучить на своем коде, вы получаете универсальный инструмент, который не знает вашей специфики.

- Фрагментированная архитектура. Часто автодополнение, поиск по коду и новомодные агенты — это продукты от разных вендоров. Склеить их вместе — головная боль. Это приводит к рассинхрону, проблемам с передачей контекста и лишним операционным расходам.

- Отсутствие контроля и наблюдаемости. Команды не видят, как именно разработчики используют AI. Без централизованного аудита, телеметрии и политик безопасности невозможно ответственно масштабировать использование AI и, что немаловажно для бизнеса, оценить реальный возврат инвестиций (ROI).

Для крупных игроков это не какие-то мелочи, а базовые требования к любому инструменту. Mistral утверждает, что их стек решает все эти проблемы. Проверим.

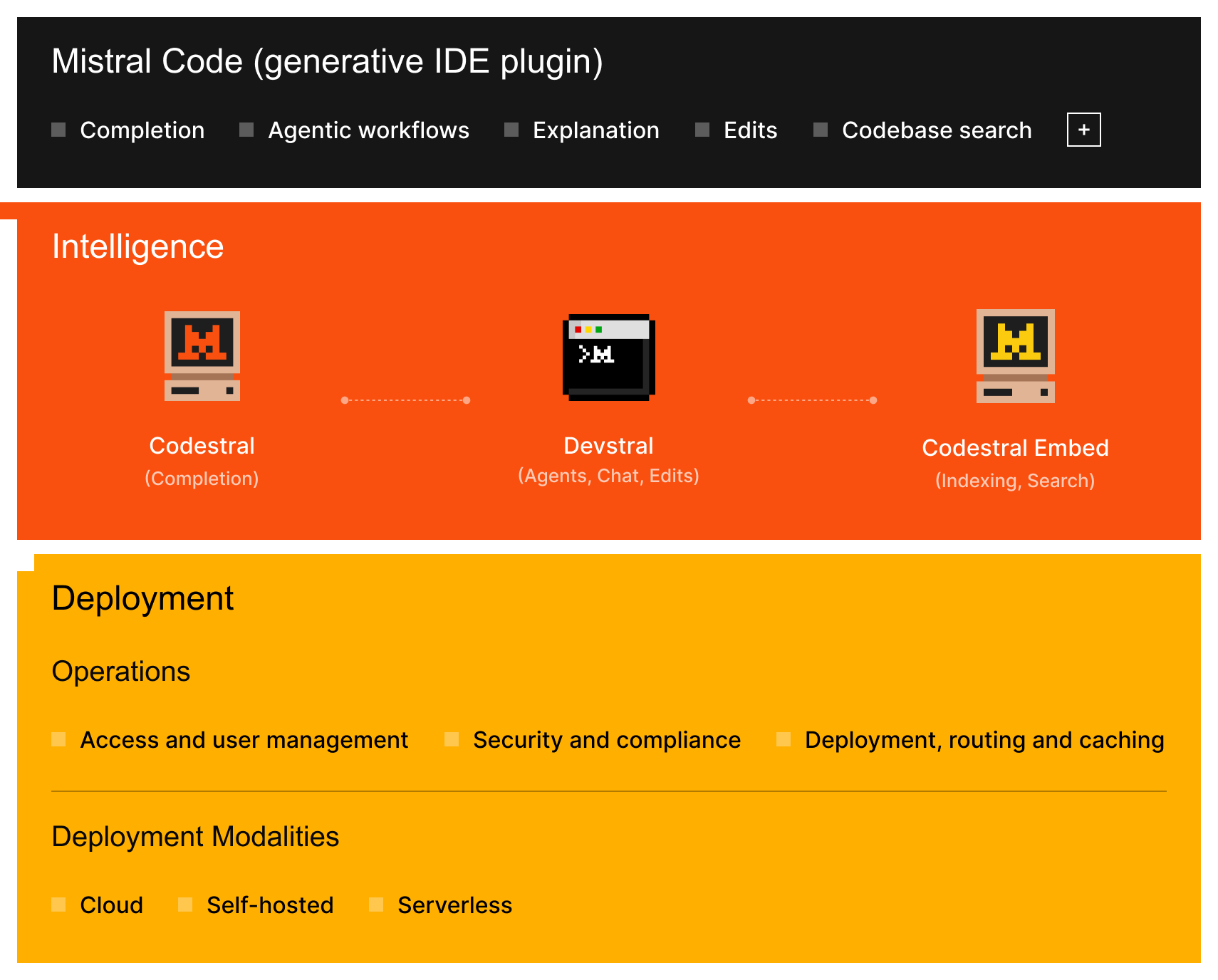

Анатомия стека Mistral: три уровня AI-помощи

Подход Mistral — это интегрированная система, где каждый слой решает свою задачу, и вместе они создают то, что можно назвать AI-native платформой для разработки.

Уровень 1: Фундамент — Быстрое автодополнение (Codestral 25.08)

В основе всего лежит семейство моделей Codestral, заточенных под одну задачу: генерация кода и, в частности, высокоточное заполнение в середине (Fill-in-the-Middle, FIM). Это именно то, что вы ожидаете от автодополнения в IDE.

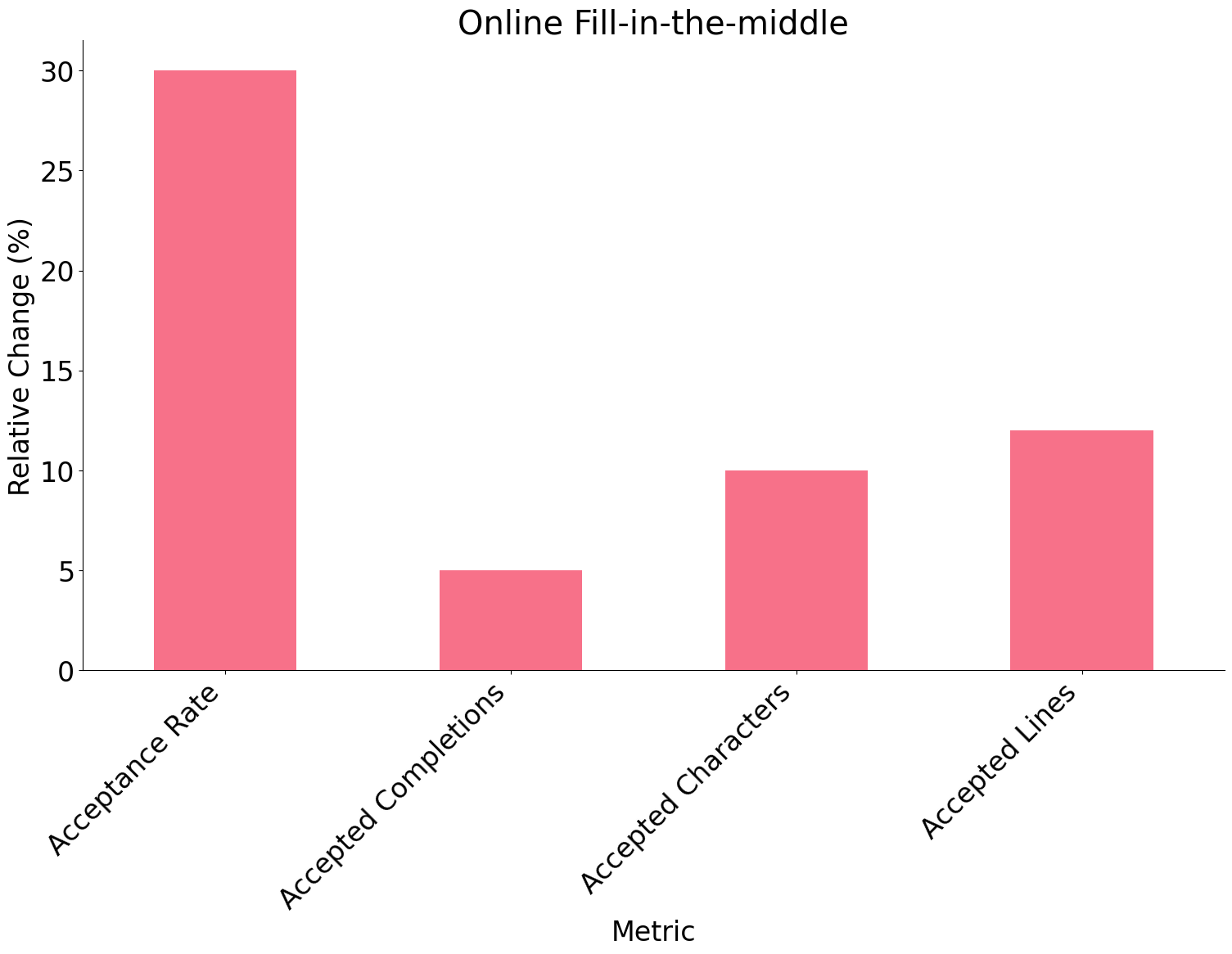

Свежая версия Codestral 25.08 принесла измеримые улучшения:

- На 30% больше принятых предложений кода.

- На 10% больше оставленного кода после того, как разработчик принял সাজেশন.

- На 50% меньше «убегающих» генераций (когда модель начинает нести чушь), что повышает доверие к длинным дополнениям.

[!INFO] Эти метрики проверялись на живом использовании в IDE на реальных продакшн-кодовых базах, а не только на синтетических академических бенчмарках.

Модель поддерживает кучу языков и, что ключевое, может быть развернута где угодно — в облаке, VPC или на вашем железе без каких-либо архитектурных изменений.

Уровень 2: Контекст — Семантический поиск по кодовой базе (Codestral Embed)

Автодополнение хорошо, но оно бесполезно, если модель не понимает контекст вашей кодовой базы. И здесь в игру вступает Codestral Embed. Это модель для создания векторных представлений (эмбеддингов), специально натренированная на коде, а не на обычном тексте.

Mistral утверждает, что она превосходит ведущие модели эмбеддингов от OpenAI и Cohere в задачах поиска по коду.

Ключевые фишки:

- Быстрый поиск с высокой точностью по гигантским моно- и поли-репозиториям. Разработчик может прямо в IDE спросить на естественном языке: «Как у нас обрабатываются таймауты от Stripe в процессе оплаты?» и получить релевантный код.

- Гибкие эмбеддинги. Можно настраивать размерность векторов (например, 256-dim, INT8), чтобы найти баланс между качеством поиска и стоимостью хранения.

- Приватное развертывание. Никаких утечек данных через сторонние API. Вся индексация и поиск могут работать внутри вашего периметра.

Этот слой — фундамент для контекста, на котором будут работать агенты, и движок для поиска по коду прямо в IDE.

Уровень 3: Действие — Автономные рабочие процессы (Devstral)

Если у нас есть контекст, искусственный интеллект может начать выполнять осмысленные, многошаговые задачи. За это отвечает Devstral — система агентных воркфлоу, построенная на базе фреймворка OpenHands. Она создана специально для сложных инженерных задач: кросс-файловый рефакторинг, генерация тестов, написание документации и даже подготовка Pull Request'ов.

Что выделяет Devstral:

- Неплохая производительность на бенчмарках.

Devstral Mediumпоказывает результат в 61.6% наSWE-Bench Verified, обгоняя Claude 3.5, GPT-4.1-mini и другие модели. - Гибкая архитектура для любого окружения. Devstral существует в нескольких размерах.

Devstral Small(24B, лицензия Apache-2.0) — это открытая модель, которую можно запустить на одной видеокарте NVIDIA RTX 4090 или даже на Mac с 32 ГБ RAM. Идеальный вариант для self-hosted развертывания, экспериментов и работы в изолированных сетях.Devstral Medium— более мощная модель, доступная через API Mistral и для корпоративных партнеров.

- Открытость и расширяемость. Команды могут взять

Devstral Smallи дообучить его на своей проприетарной кодовой базе, создавать кастомных агентов или встраивать его прямо в CI/CD пайплайны. Никакого vendor lock-in.

Возможность запускать таких агентов внутри своей инфраструктуры — это именно то, чего так не хватало enterprise-сегменту для автоматизации разработки без рисков для безопасности.

Сборка: Как все это работает вместе в IDE (Mistral Code)

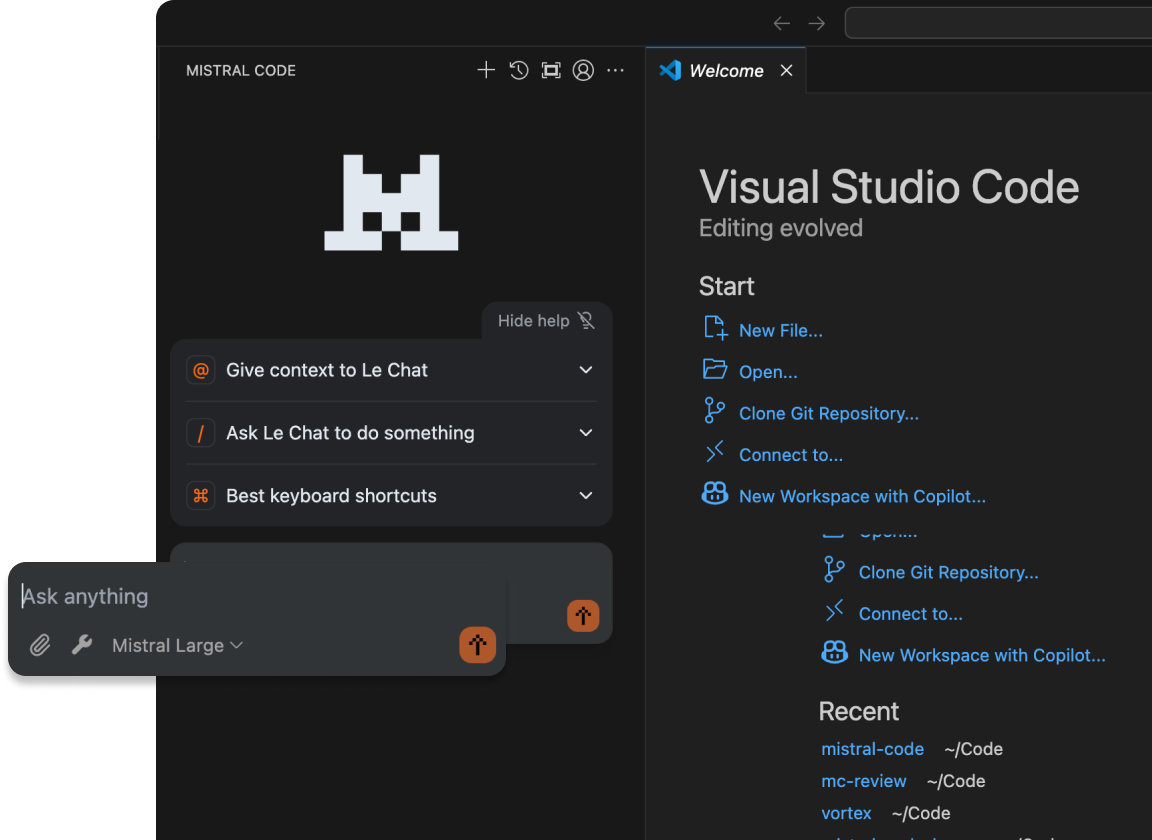

Вся мощь стека — автодополнение, поиск и агенты — становится доступной через Mistral Code, нативный плагин для VS Code и JetBrains IDEs.

Что он умеет:

- Инлайн-автодополнение от

Codestral 25.08. - Автоматизация задач в один клик: "Напиши коммит-сообщение", "Почини эту функцию", "Добавь докстринги" — все это на мощностях

Devstral. - Осведомленность о контексте: плагин учитывает изменения в Git, историю команд в терминале и выводы инструментов статического анализа.

- Интегрированный семантический поиск на базе

Codestral Embed.

Плагин спроектирован с учетом требований корпоративной безопасности и управления:

- Развертывание где угодно: облако, VPC или on-prem (полноценная поддержка ожидается в Q3 2025).

- Никакой обязательной телеметрии и внешних вызовов API.

- Поддержка SSO, логирование аудита и централизованное управление для безопасного внедрения.

- Панель мониторинга в консоли Mistral для отслеживания использования AI, процента принятия подсказок и работы агентов.

Типичный сценарий: от локальной правки до рефакторинга в масштабе репозитория

Давайте представим реальную задачу, чтобы понять, как этот стек меняет рабочий процесс.

Допустим, разработчик работает над платежным сервисом на Python. Недавно обновился сторонний API для биллинга, и нужно обновить логику интеграции и добавить корректную обработку ошибок.

Автодополнение. Разработчик начинает менять сигнатуру функции-обработчика.

Codestralтут же предлагает ожидаемые параметры и базовую реализацию, избавляя от необходимости искать и копировать похожие паттерны из других частей сервиса.Семантический поиск. Прежде чем менять логику повторных запросов (retry logic), нужно понять, как похожие ошибки обрабатываются в других местах. Вместо того чтобы идти в Slack или вручную грепать репозиторий, он прямо в IDE пишет запрос:

«Как мы обрабатываем таймауты Stripe в процессе оформления заказа?». Локально развернутыйCodestral Embedнаходит и показывает вспомогательный модуль из другого сервиса, который реализует retry-логику с экспоненциальной задержкой.Агентный рефакторинг. Разработчик копирует паттерн в свой обработчик, но понимает, что еще три сервиса используют устаревший код. Он вызывает агента

Devstralс задачей:«Замени все использования retry_with_sleep в сервисах биллинга и оформления заказа на новый хелпер retry_exponential и обнови документацию».- Devstral сканирует кодовую базу (используя те же эмбеддинги), вносит правки в нескольких файлах и генерирует черновик Pull Request.

- Агент также пишет чейнджлог и обновляет README в разделе обработки ошибок.

Ревью и мерж. Разработчик просматривает готовый PR, убеждается в корректности логики и мержит его.

[!TIP] Задача, которая раньше требовала поиска, координации с другими командами и рутинного написания кода, может выполняться за одну рабочую сессию. При этом результат работы агента полностью отслеживаемый и проходит стандартный процесс код-ревью.

Mistral Stack vs. GitHub Copilot: лобовое столкновение

Теперь, когда мы разобрались с компонентами, давайте проведем прямое сравнение с главным конкурентом по ключевым параметрам, которые важны для разработчиков и бизнеса.

| Параметр | GitHub Copilot (Enterprise) | Mistral Coding Stack | Победитель (для кого?) |

|---|---|---|---|

| Модель развертывания | SaaS-only (Azure Cloud) | Cloud, VPC, On-Premise, Air-gapped | Mistral. Очевидный выбор для компаний с жесткими требованиями к безопасности и суверенитету данных. |

| Контроль над данными | Данные обрабатываются в облаке Microsoft/GitHub | Полный контроль, данные не покидают периметр компании (при on-prem) | Mistral. Критически важно для regulated-индустрий (финансы, медицина, оборонка). |

| Кастомизация/Fine-tuning | Ограниченные возможности кастомизации | Полный доступ к дообучению Devstral Small на собственных данных. Возможность fine-tuning Medium версии для enterprise-клиентов. |

Mistral. Позволяет адаптировать AI под уникальную кодовую базу и внутренние стандарты. |

| Возможности "из коробки" | Отличное автодополнение, чат, базовые команды (fix, docs) | Автодополнение, семантический поиск по коду, многошаговые агентные воркфлоу (рефакторинг, генерация PR) | Mistral. Предлагает более мощные и сложные инструменты автоматизации "из коробки". |

| Экосистема и интеграция | Глубокая интеграция с экосистемой GitHub (Actions, Issues) | Нативный плагин для VS Code / JetBrains, но требует усилий для глубокой интеграции с внутренними CI/CD и другими системами. | Copilot. Выигрывает за счет бесшовной интеграции в устоявшуюся экосистему GitHub. |

| Порог входа | Очень низкий. Установил плагин и работаешь. | Выше. Требует развертывания и настройки (особенно on-prem), но предлагает опцию "просто попробовать" через API. | Copilot. Идеален для индивидуальных разработчиков и небольших команд без DevOps-ресурсов. |

| Прозрачность работы | "Черный ящик". Сложно понять, почему предложено то или иное решение. | Открытая модель Devstral Small позволяет исследовать ее поведение. Возможность аудита и логирования всех действий. |

Mistral. Дает больше контроля и понимания того, что происходит "под капотом". |

Понравился материал?

Ваша поддержка — это энергия для новых статей и проектов. Спасибо, что читаете!

Выводы: кому и когда переходить на стек Mistral?

Вам точно стоит присмотреться к Mistral, если:

- Вы работаете в enterprise-сегменте или регулируемой отрасли. Возможность развернуть весь стек на своих серверах, полностью контролировать данные и соответствовать требованиям комплаенса — это не просто фича, а необходимое условие. Для вас Copilot, скорее всего, был под запретом, и Mistral — это первый реальный шанс внедрить современный AI-ассистент.

- У вас огромная и сложная проприетарная кодовая база. Возможность дообучить модель на своем коде — это огромный плюс. Агент, который знает ваши внутренние фреймворки и библиотеки, будет на порядок полезнее универсального помощника.

- Вы хотите строить собственные AI-инструменты. Открытость

Devstral Smallи доступ к модели эмбеддингов позволяют использовать компоненты стека как строительные блоки для кастомных решений, интегрированных в ваш CI/CD или другие внутренние платформы. - Вы просто цените приватность и контроль. Даже если вы не корпорация, идея о том, что ваш код никуда не отправляется, а AI-помощник работает локально, может быть очень привлекательной. Сборка на RTX 4090 — уже не выглядит как что-то заоблачное для небольшой команды или даже отдельного энтузиаста.

Когда GitHub Copilot все еще может быть лучшим выбором:

- Для индивидуальных разработчиков и небольших команд. Простота использования и бесшовная интеграция с GitHub перевешивают все остальное. Вам не нужно думать об инфраструктуре.

- Если вы уже глубоко интегрированы в экосистему GitHub. Copilot, завязанный на Issues, Actions и другие сервисы, будет работать гармоничнее.

В сухом остатке, Mistral предлагает гибкую и открытую альтернативу для тех, для кого Copilot был неприемлем по соображениям безопасности, контроля и кастомизации. От универсальных SaaS-игрушек мы переходим к серьезным, конфигурируемым платформам, которые можно адаптировать под реальные нужды сложного бизнеса. И это, безусловно, хорошая новость для всей индустрии.